Robots.txt

Robots.txt veileder søkemotorer og bots i indeksering og tilgang til innhold på et nettsted. Den lar nettsideeiere styre hvilke deler av nettstedet som skal indekseres og hvilke som skal holdes skjult for søkemotorer.

Hva er Robots.txt?

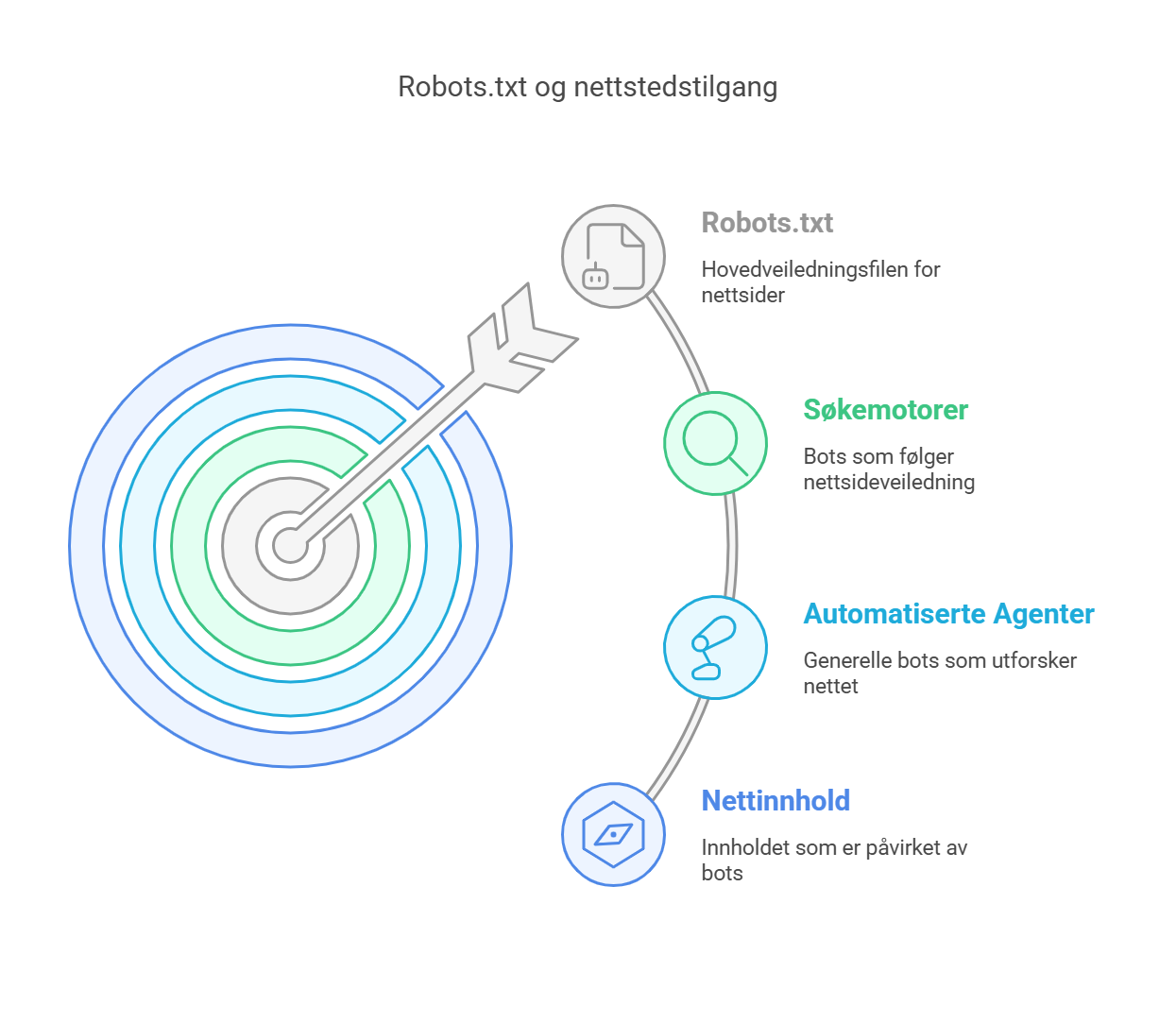

Robots.txt er en tekstfil som fungerer som veiledning for søkemotorer og andre automatiserte agenter (også kalt "nettlesere" eller "bots") angående indeksering og tilgang til innholdet på en nettside.

Denne filen lar eieren av et nettsted styre hvilke deler av nettstedet som skal indekseres og hvilke som skal holdes skjult for søkemotorer. Dette gjøres ved å inkludere eller ekskludere spesifikke URL-er eller mapper fra prosessen med indeksering.

Hvordan fungerer Robots.txt?

Plassert i roten av et nettsted, er robots.txt-filen tilgjengelig ved å legge til "/robots.txt" etter domenenavnet (slik: eksempel.com/robots.txt). Søkemotorer og andre automatiserte agenter leser filen før de starter indekseringen av en nettside for å få veiledning om hvilke deler av nettstedet de har tillatelse til å besøke og indeksere.

Filen inneholder flere regler som er organisert i "User-agent" og "Disallow"-direktiver. "User-agent" refererer til navnet på søkemotoren eller boten som instruksjonene gjelder for, mens "Disallow"-direktivet angir hvilke URL-er eller mapper som skal utelates fra indeksering.

Hvordan bruke Robots.txt i praksis?

Her er et eksempel på en grunnleggende robots.txt-fil:

User-agent: *

Disallow: /privat/

Disallow: /internt/

I dette eksemplet betyr "User-agent: *" at instruksjonene gjelder for alle søkemotorer og bots. "Disallow"-direktivene indikerer at søkemotorer ikke bør indeksere innholdet i "/privat/" og "/internt/" mappene.

Det er viktig å understreke at robots.txt-filen kun fungerer som en anbefaling for søkemotorer, og ikke alle bots vil nødvendigvis følge instruksjonene.

Forøvrig gir ikke robots.txt-filen beskyttelse mot uautorisert tilgang eller hacking. For å sikre sensitivt innhold, bør du benytte andre sikkerhetstiltak, som for eksempel passordbeskyttelse og tilgangskontroll.

Oppsummering

Bruke robots.txt på riktig måte slik at du kan forbedre søkemotoroptimaliseringen (SEO) ved å hindre søkemotorer i å indeksere uønsket eller irrelevant innhold. Rett heller fokuset mot de mest relevante og verdifulle delene av nettstedet ditt.